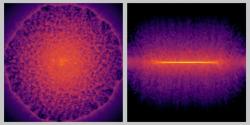

Ať už žijeme v potměšilé počítačové simulaci či nikoliv, naše vlastní simulace vesmírných objektů jsou stále lepší a lepší. Japonští odborníci úspěšně simulovali Mléčnou dráhu, přičemž simulace reprezentovala více než 100 miliard jednotlivých hvězd. Nová simulace tím pádem zahrnula stokrát víc hvězd než dosavadní nejlepší modely, a ještě navíc byla hotová stokrát rychleji.

Tým, který vedl Keiya Hirashima z RIKENu, toho dosáhl propojením umělé inteligence s počítačovými simulacemi. Jejich simulace představuje průlom v astrofyzice, extrémních výpočtech i umělé inteligenci. Postup japonských vědců bude možné uplatnit i za hranicemi astrofyziky, například v modelování klimatu.

Astrofyzici se již dlouho pokoušejí simulovat Mléčnou dráhu na úrovni hvězd. Takovou simulaci by bylo možné použít k testování vývoje a struktury galaxií i vývoje hvězd. Přesné modely vývoje galaxií ale zahrnují spoustu faktorů a jsou velice, velice náročné na výpočty. Dosavadní modely byly omezené na 1 miliardu „částic,“ které by v reálné situaci odpovídaly seskupením hvězd o hmotě více než 100 Sluncí.

Současně byly tyto modely tak výpočetně složité, že simulovat jediný milion let vývoje Mléčné dráhy (kterou představovala zmíněná miliarda částic), trvalo asi 315 hodin. Další problém byl v tom, že přidávat další a další superpočítačová jádra by nebylo nejlepším řešením. Kromě nárůstu spotřeby energie by také klesala účinnost výpočetního procesu.

Hirashima a spol. proto udělali pověstný úkrok stranou a povolali umělou inteligenci, kterou vycvičili na simulacích supernovy ve vysokém rozlišení. Pak tuto inteligenci zapojili do simulace, která tím pádem modeluje celkovou dynamiku galaxie a současně i procesy na jemnější škále galaktické evoluce, jako jsou exploze supernov.

Simulace podpořené AI testovaly superpočítače Fugaku z RIKENu a Miyabi na University of Tokyo. Zvládly rozlišení na 100 miliard částic, což víceméně odpovídá jednotlivým hvězdám a simulace 1 milionu let vývoje galaxie trvala 2,78 hodin. S takovou rychlostí by bylo možné simulovat 1 miliardu let vývoje galaxie za 115 dní, což už je relativně únosné. Nezbývá než se těšit na příště.

Video: Supercomputer Fugaku

Literatura

Illustris: The Next Generation je nejpokročilejší simulací vesmíru

Autor: Stanislav Mihulka (02.02.2018)

Umělá inteligence poprvé simulovala vesmír: Rychle, přesně a nikdo neví jak

Autor: Stanislav Mihulka (27.06.2019)

Simulace superpočítače ATERUI přetočily zpátky kosmické hodiny

Autor: Stanislav Mihulka (21.02.2021)

„Kvantová simulace“ předvedla vesmír v první biliontině sekundy

Autor: Stanislav Mihulka (28.03.2021)

Rekordní simulace na Frontieru ohlašuje exakapacitní éru výzkumu vesmíru

Autor: Stanislav Mihulka (27.11.2024)

Diskuze:

Simulácie bez všetkých potrebných znalostí?

Ilil Akil,2025-11-21 02:20:13

Aký má zmysel robiť také simulácie, keď sa nevie, čo je a aký má presne vplyv temná hmota?

Tá má vraj výrazne ovplyvňovať pohyb hviezd v galaxiách.

Re: Simulácie bez všetkých potrebných znalostí?

Pavel Kaňkovský,2025-11-21 15:05:54

Třeba právě proto. Můžete nasimulovat vývoj galaxií za různých předpokladů (včetně předpokladů o chování temné hmoty) a pak eliminovat ty varianty, které zjevně nesouhlasí s pozorováním.

Re: Re: Simulácie bez všetkých potrebných znalostí?

F M,2025-11-25 10:43:22

Dokonce si myslím, že když řeknu, že temná hmota je právě ten rozdíl mezi simulací bez ní a tím co se pozoruje, tak to bude poměrně hodně přesné (přesně? Asi).

Re: Simulácie bez všetkých potrebných znalostí?

František F,2025-11-22 09:15:27

Temná hmota? Dokud si zacpáváme uši a zavíráme oči, jen sami vymýšlíme svoje, pak je chůze pomalá.

Re: Re: Simulácie bez všetkých potrebných znalostí?

Pavel Kaňkovský,2025-11-22 13:09:21

Tak holt budete muset nějakou lepší teorii vymyslet sám. ;)

Re: Re: Re: Simulácie bez všetkých potrebných znalostí?

František F,2025-11-22 16:55:01

To bych se, ohledně temné hmoty, zařadil mezi ty, co vymýšlejí sami. Lépe nahlížet jinam.

Re: Re: Re: Re: Simulácie bez všetkých potrebných znalostí?

Pavel Kaňkovský,2025-11-23 14:08:31

Nebuďte slušnej! Řekněte, kam máme nahlížet!

Re: Re: Re: Re: Re: Simulácie bez všetkých potrebných znalostí?

František F,2025-11-23 21:31:07

Když tedy nechci jen vymýšlet ze svého mozku a napájím se i od cizích, nezavřu oči a nezacpu uši:

(Prý: otevřít se možnostem, které jste zde neviděli)

https://kryon.webnode.cz/news/nejvetsi-filtr-ze-vsech/

pěkné např: https://kryon.webnode.cz/news/kvantovy-faktor-fyzika-s-postojem/

https://kryon.webnode.cz/news/fyzika-v-pristich-500-letech/

Snad neurazím. F.

Jiri Kamecek,2025-11-20 20:16:14

Optimalizace je fajn, ale smysl proč simulovat miliardu hvězd, co bude dělat za miliardu let mi uniká. Pokud nám to možná něco řekne , tak to určitě počká do doby, kdy ty simulace nebudou trvat 100 dní na superpočítači, ale 100 hodin na obyčejném PC.

Jiri Kamecek,2025-11-19 19:34:16

Nejsem si jistý, jestli v tomto případě pálit MWh energie stojí za výsledek.

Re:

Pavel Kaňkovský,2025-11-20 18:50:25

Tím myslíte to, že se tato konkrétní optimalizace nevyplatila, nebo obecně to, že by se neměla energie spotřebovávat na nějaké výpočty, ze kterých nemají pracující žádný užitek?

Re: Re:

Jiri Kamecek,2025-11-20 20:16:47

Optimalizace je fajn, ale smysl proč simulovat miliardu hvězd, co bude dělat za miliardu let mi uniká. Pokud nám to možná něco řekne , tak to určitě počká do doby, kdy ty simulace nebudou trvat 100 dní na superpočítači, ale 100 hodin na obyčejném PC.

Re: Re: Re:

D@1imi1 Hrušk@,2025-11-20 21:04:39

A to bude konkrétně kdy? Moorovo pravidlo, že každých 18 měsíců se zdvojnásobí počet tranzistorů, které dokážeme umístit na jeden čip, už pár let neplatí, protože se rozměry tranzistorů přiblížily fyzikálním limitům. Zvyšování výkonnosti HW se už děje hlavně hledáním nových triků, ale i to má svoje limity a hlavně je to mnohem pomalejší. Dřív platilo, že za dva roky si koupíte počítač s dvojnásobným výpočetním výkonem, teď to zlepšení po dvou letech můžete očekávat maximálně o desítky procent. A může se to časem zastavit téměř úplně. Když někdo přijde s radikálně jinou koncepcí než s křemíkovými čipy, může se ten pokrok opět nastartovat, ale zatím tady nic takového není a pokud se nic takového neobjeví, pochybuji, že někdy domácí PC bude stejně výkonné, natož výkonnější než současné superpočítače.

Jinak k čemu jsou takové simulace přínosné? Třeba k tomu, abyste věděl, na co se zaměřovat se současnými teleskopy, případně jaké stavět nové. Zároveň se tím vyvíjejí způsoby, jak zapojit do simulací na superpočítačích umělou inteligenci. Máte to i v článku: "Postup japonských vědců bude možné uplatnit i za hranicemi astrofyziky, například v modelování klimatu."

Re: Re: Re: Re:

Jiri Kamecek,2025-11-21 00:17:13

Moorovo pravidlo skutečně už notně zvolnilo, ale to platí hlavně pro výkonost jednoho jádra, frekvence už nahoru téměř nejdou a zmenšování tranzistoru má pře sebou tak 2 nebo 3 generace a bude asi konečná. Ale kde jsou ještě reservy je množství jader a jejich paralení spolupráce . A právě u simulací je paralelní výpočet více jader ještě faktor, který má podle mne velké reservy. Takže třeba za 10 let bude možné zrychlení simulací určitě 10ti a možná i 100 násobné. A pak jedině kvantové počítače, ale to je v praktických výpočtech zatím scifi, tam se nic odhadovat nedá.

Re: Re: Re: Re: Re:

D@1imi1 Hrušk@,2025-11-21 01:25:56

Zvýšením počtu jader zvýšíte jak výpočetní, tak tepelný výkon, který musíte uchladit a samozřejmě spotřebu elektřiny. Takže tímto způsobem se výpočetní výkon moc posouvat nedá - zvláště u systémů, které už teď s velkou mírou paralelismu pracují (superpočítače a moderní AI čipy). Výpočetní výkon čipů v poměru ke spotřebě lze zlepšit například snížením pracovního napětí tranzistorů a elektrické kapacity jednotlivých součástek, ale tam už se právě přibližují fyzikálním limitům. Další zlepšení by mohly přinést čipy se složitou 3D architekturou - kdyby je někdo uměl sériově vyrábět (a chladit). Každý nový trik přinese zlepšení pouze jednou a triky postupně dojdou.

Ale oceňuji, že už jste alespoň slevil z PC, které spočítá za hodinu to, co dnešní superpočítač za den na superpočítač, který bude desetkrát výkonnější než ten současný.

Re: Re: Re: Re: Re: Re:

F M,2025-11-25 11:22:29

Teď dost záleží jakou architekturu vezmete jako základ, dokonce jsou řady (Intel) kdy je novější pomalejší (ale má o pár jader víc). Každopádně to bude dvojnásobek na jádro spíš za 10 let než 2r, celkově tak 4x jak v čom, beru tak střed na střed (i5). Počet jader je záludný, těch výkonných až tolik nepřibývá. Pravda je, že před 20-30 lety by to bylo komické, ten rozdíl v generaci by byl mezi modely (hz) jedné generace tedy třeba 5 a pak skok o deset i víc (současným marketingovým způsobem). SDD disky?

Je zajímavé jak se u těchto otázek AI kroutí, lepím to z hlavy prakticky bez korekce.

Jak to půjde dál? Dokud budou lidé (organizace) kupovat, tak nebude důvod nevyrábět. Zavedení něčeho nového? Otázka je cena, může to být takový ranec (dohnat ten náskok), že to nikdo nezaplatí? Zpětná kompatibilita (software), ta dělá problémy i v rámci prakticky totožných (relativně) procesorů.

Re: Re: Re: Re: Re:

Pavel Kaňkovský,2025-11-21 15:19:04

Možná byste si měl přečíst ten originální článek. Ta jejich inovace se právě týká škálování simulace na hodně paralelně pracujících jader. Problém je v tom, že některé jevy (jmenovitě ty supernovy) se musejí počítat ve větším detailu, což celou simulaci významně zdržuje, ale oni jsou to schopni obejít.

Diskuze je otevřená pouze 7dní od zvěřejnění příspěvku nebo na povolení redakce