V poslední době vzbudily velký rozruch deepfake systémy s umělou inteligencí, které dovedou vyrobit méně či více přesvědčivou videokopii nějaké reálné osoby. Anebo audiokopii, kde je to ještě jednodušší. Z takových technologií jde strach. Deepfake podvrhy politiků a celebrit se stávají problémem pro fungování společnosti, například během volebních kampaní či krizí.

Hlasové podvrhy mohou zasáhnout kohokoliv. Když vám někdo zavolá, nemůžete si už být úplně jistí, zda to je anebo není člen rodiny či přítel v závažné nouzi. Další problém spočívá v tom, že takový deepfake může posloužit k prolomení ochrany založené na rozpoznávání hlasu. Otázkou je, jak se proti takovým technologiím bránit.

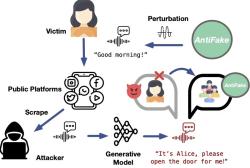

Už se objevily metody, které umožňují do určité míry rozpoznat, že máme co do činění s audio nebo videopodvrhem. Jsou ale i jiné možnosti. Ning Zhang z americké Washington University in St. Louis a jeho kolegové vyvinuli inteligenci AntiFake, která jako jedna z prvních umožňuje chránit hlas před tvorbou deepfake podvrhů. Taková inteligence zařídí, že pro deepfake inteligence bude mnohem obtížnější naklonovat lidský hlas.

Zhang shodou okolností použil pro dobrou věc technologii temné strany. AntiFake je založená na nástroji z výbavy kyberzločinců, ale teď, jak říká Zhang, nás může před kyberzločinci chránit. V podstatě jde o to, že AntiFake naruší mluvený hlas člověka pro elektronická zařízení natolik, že si s ním deepfake inteligence neporadí.

Pokud se deepafake inteligence pokusí vytvořit klon hlasu chráněného inteligencí AntiFake, výsledek se vůbec nepodobá původnímu lidskému hlasu. Dosavadní testy ukázaly, že ochrana AntiFake je úspěšná zhruba v 95 procentech případů. Zároveň se zdá, že tohle je situace, do které se vloží nelítostná Červená královna. Dojde k závodu ve zbrojení, v němž budou soupeřit pokročilé deepfake inteligence s pokročilými obrannými inteligencemi. Do budoucna máme o zábavu postaráno.

Technologie AntiFake je kompletně volně dostupná zde.

Video: Deepfake: Tips to identify and safeguard yourself from this AI-powered hoax

Literatura

Konverzační inteligence ChatGPT halucinuje simulace Linuxu a inteligencí

Autor: Stanislav Mihulka (07.12.2022)

Ghostwriter je strašidelný psací stroj posedlý umělou inteligencí GPT-3

Autor: Stanislav Mihulka (15.12.2022)

Inteligence GPT-4 si najala člověka kvůli překonání testu CAPTCHA. A lhala mu

Autor: Stanislav Mihulka (17.03.2023)

Experiment Wolwerine: Inteligence GPT-4 zrodila samoopravné programy

Autor: Stanislav Mihulka (12.04.2023)

Umělou inteligenci DarkBERT vycvičili na temné straně internetu

Autor: Stanislav Mihulka (26.05.2023)

Podvádění podvodníků: Bezpečnostní experti povolali bohyni Apaté

Autor: Stanislav Mihulka (02.07.2023)

Diskuze: